Der eigentliche Wert von Künstlicher Intelligenz: Die Synthese aus thematischer Breite und maschineller Präzision

- Johannes Humbert

- 16. Dez. 2025

- 3 Min. Lesezeit

Aktualisiert: 16. Dez. 2025

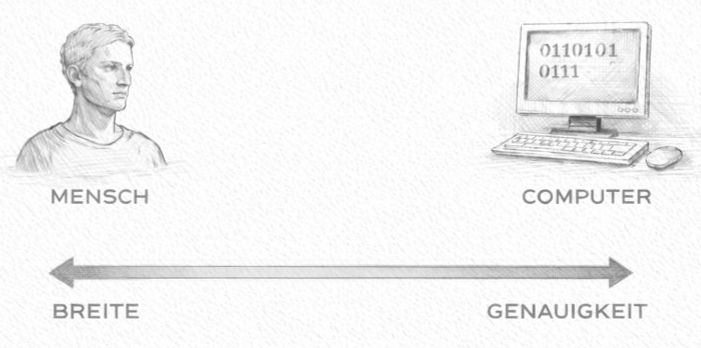

Über Jahrzehnte hinweg haben wir in zwei fundamental unterschiedlichen Intelligenz-Räumen gearbeitet: dem des Computers und dem des Menschen. Beide sind extrem leistungsfähig – aber jeweils genau dort, wo der andere strukturell versagt.

Was wir heute mit moderner Künstlicher Intelligenz beobachten, ist nicht einfach ein weiteres Werkzeug. Es ist die Entstehung eines dritten Intelligenz-Raums, der die beiden anderen erstmals sinnvoll miteinander verbindet.

Diese Unterscheidung ist zentral, wenn man verstehen will, was KI tatsächlich ist, wo ihr realer Wert liegt – und wie sie sinnvoll in Produkte und Systeme eingebaut werden sollte.

Raum 1: Computer – perfekte Logik, keine Breite

Computer sind im Kern deskriptive Maschinen.

Sie sind nichts anderes als eine Abstraktion von Mathematik. Nicht mehr – aber auch nicht weniger.

Wenn die Logik korrekt definiert ist und das System fehlerfrei funktioniert, dann ist das Ergebnis zu 100 % vorhersehbar.

1 + 1 wird immer 2 ergeben.

Das ist zugleich die große Stärke und die fundamentale Grenze klassischer IT:

Stärke: vollständige Deterministik, keine Mehrdeutigkeit, keine Widersprüche

Grenze: Der Computer kann ausschließlich innerhalb dessen operieren, was explizit definiert wurde

Ein Computer versteht die Welt nicht. Er führt Logik auf einem Modell der Welt aus.

Genau deshalb fühlt sich (minderwertige) Digitalisierung oft an wie Bürokratie. Sie abstrahiert Realität. Manchmal passt diese Abstraktion sehr gut. Oft passt sie nicht.

Wenn die Abstraktion stimmt, wirken digitale Werkzeuge elegant und mächtig.

Raum 2: Menschen – enorme Breite, inhärente Unsicherheit

Menschen funktionieren grundlegend anders. Menschen sind biologische Vorhersagemaschinen:

Wir generalisieren.

Wir schließen aus unvollständigen Informationen.

Wir handeln unter Unsicherheit.

Wir tolerieren Widersprüche.

Wir sind nicht logisch "rein". Wir sind voreingenommen, emotional, inkonsistent – und oft schlicht falsch.

Aber genau diese „Unschärfe“ ist unsere Stärke:

Wir können in schlecht definierten Domänen agieren.

Wir kommen mit Ambiguität und Kontextwechseln zurecht.

Wir können handeln, auch wenn es kein formales Modell gibt.

Menschen decken eine enorme Breite der Realität ab – weit jenseits dessen, was klassische Software abbilden kann.

Der Trade-off ist klar:

Hohe Breite

Geringe Konsistenz, Wiederholbarkeit und Fehlerfreiheit

Die klassische Trennung

Über lange Zeit war diese Trennung absolut:

Computer:hohe Genauigkeit, geringe Breite

Menschen:hohe Breite, geringe Zuverlässigkeit

Digitalisierung versucht(e), menschliche Prozesse in Logik zu pressen.

Manchmal funktionierte das. Oft nicht.

Diese Spannung hat Enterprise-Software, Bürokratie und die Frustration mit IT über Jahrzehnte geprägt.

Raum 3: Künstliche Intelligenz – Breite trifft Determinismus

Moderne KI – insbesondere Large Language Models – eröffnet einen dritten Raum.

Nicht, weil sie „intelligent“ im menschlichen Sinne wäre, sondern weil sie Eigenschaften beider Welten kombiniert:

Von Computern:

Ausführbarkeit

Skalierbarkeit

Integration in deterministische Systeme

Von Menschen:

Breite des Verständnisses

Kontextsensitivität

Flexibilität im Umgang mit Unsicherheit

Der entscheidende Punkt ist jedoch dieser:

KI wird erst dann wirklich relevant, wenn sie in Systeme eingebettet wird, die sie in Richtung nahezu fehlerfreier Ausführung treiben.

Ein reines Modell reicht allein nicht.

Die eigentlich relevante Achse

Die Entwicklung von KI sollte nicht primär über Modellgrößen, Benchmarks oder Hype-Zyklen betrachtet werden.

Die relevante Achse ist eine andere:

Breite des Verständnisses vs. Genauigkeit der Ausführung

Klassische IT: geringe Breite, nahezu Null-Fehler.

Menschen: enorme Breite, hohe Varianz und Fehlerquote.

KI-gestützte Systeme: potenziell enorme Breite UND potenziell nahezu Null-Fehler.

Das ist die Brücke.

Und diese Brücke entsteht nicht allein im Modell.

Warum KI gestützte Produkte wichtiger sind als Modelle

Große Technologieanbieter versuchen, dieses Problem im Modell zu lösen und überschlagen sich mit immer neuen Modellgenerationen, die oft nur noch inkrementell besser sind. Natürlich wird dieser Ansatz teilweise auch Ergebnisse zeigen. Allerdingst wird dies Zeit und erhebliche Mittel brauchen.

Der viel naheliegendere Hebel liegt in der Produktarchitektur:

Guardrails

Validierungsschichten

Human-in-the-Loop-Konzepte

Strukturierte Ein- und Ausgaben

Domänenspezifische Einschränkungen

Dasselbe Modell kann:

in einem Produkt unzuverlässig sein

in einem anderen nahezu fehlerfrei arbeiten

Die „Intelligenz“ liegt nicht nur im Modell. Sie liegt in der Art, wie das System darum gebaut ist.

Warum das transformativ ist

Dieser Ansatz ermöglicht etwas fundamental Neues:

Aufgaben, die menschliches Verständnis erfordern, hoch variabel sind und sich nicht vollständig in Logik codieren lassen …können nun:

skalierbar

konsistent

mit nahezu Null-Fehler-Qualität

ausgeführt werden.

Diese Kombination existierte vorher nicht.

Sie erschließt ganze Arbeitskategorien, die bislang:

zu komplex für Software und

zu fehleranfällig oder teuer für Menschen waren.

Der Gedanke, den man festhalten sollte

Bei KI geht es nicht darum, Menschen zu ersetzen. Und auch nicht darum, Computer „denken“ zu lassen.

Es geht darum, einen historischen Trade-off aufzulösen:

Entweder menschliche Breite oder maschinelle Zuverlässigkeit.

Zum ersten Mal können wir realistisch beides anstreben.

Das ist der eigentliche Umbruch.